O campo de batalha da infraestrutura de IA está mudando rapidamente do treinamento para a inferência. Construir modelos poderosos é crucial, mas servi-los de forma eficiente e econômica é o que determina o sucesso dos negócios. O novo acelerador Maia 200, projetado internamente pela Microsoft, é um chip nascido exatamente para esse propósito: maximizar a eficiência em escala de nuvem para cargas de trabalho de inferência. Vamos desvendar suas inovações técnicas e implicações para o setor. Para o anúncio original, confira a publicação oficial do blog da Microsoft.

Especificações Técnicas Principais: O Que Torna o Maia 200 Tão Poderoso?

O Maia 200 é uma concentração de tecnologias de ponta, todas otimizadas para um único objetivo: inferência.

- Processo de Fabricação: Fabricado no processo de 3nm de ponta da TSMC, com mais de 140 bilhões de transistores, equilibrando alto desempenho e eficiência energética.

- Precisão de Computação: Possui núcleos tensor nativos FP8 e FP4. A computação de baixa precisão reduz a pressão na largura de banda da memória e aumenta a eficiência energética, sendo ideal para inferência. Oferece mais de 10 petaFLOPS em precisão FP4 e mais de 5 petaFLOPS em FP8.

- Sistema de Memória: Um subsistema de memória redesenhado, centrado em 216GB de memória HBM3e ultrarrápida (7TB/s de largura de banda) e 272MB de SRAM no chip, focado em alimentar rapidamente os pesos de modelos massivos.

- Envelope de Energia: Atinge o desempenho acima dentro de um TDP de SoC de 750W, maximizando o desempenho por watt. 🚀

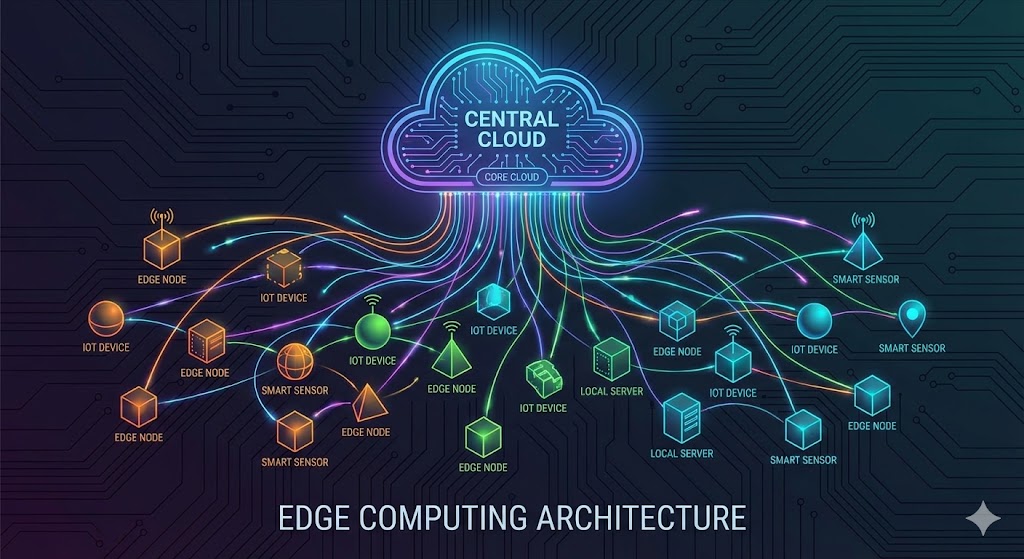

Arquitetura do Sistema & Vantagens da Integração com a Nuvem

Além do desempenho do chip único, a verdadeira força do Maia 200 está no design do sistema que os une eficientemente em escala de nuvem.

| Característica | Descrição | Benefício Prático |

|---|---|---|

| Rede de Escalabilidade em 2 Camadas | Design novo baseado em Ethernet padrão. Fornece 2.8 TB/s de largura de banda dedicada de escalabilidade. | Permite operações coletivas de alto desempenho previsíveis em clusters (até 6.144 aceleradores) sem tecidos proprietários, reduzindo o TCO. |

| Tecido Unificado | Usa o mesmo protocolo de transporte Maia AI para comunicação intra-rack e inter-rack. | Minimiza saltos de rede, simplifica a programação e melhora a flexibilidade da carga de trabalho. |

| Resfriamento Líquido | Integra uma Unidade Trocadora de Calor de resfriamento líquido de circuito fechado de segunda geração. | Garante desempenho estável em implantação de alta densidade. ❄️ |

| Integração Nativa com o Azure | Integração profunda com o plano de controle do Azure oferece segurança, telemetria e diagnósticos. | Automatiza o gerenciamento em nível de chip e rack, maximizando confiabilidade e tempo de atividade para cargas de trabalho de produção. |

Graças a este design holístico, o tempo desde o primeiro silício até a primeira implantação de rack no datacenter foi reduzido para menos da metade em comparação com programas de infraestrutura de IA similares. 😲

Aplicações e Perspectivas: O Que Significa para Desenvolvedores

O Maia 200 alimentará serviços como o Microsoft Foundry e o Microsoft 365 Copilot, além dos mais recentes modelos GPT da OpenAI, melhorando o custo e a velocidade da geração de tokens. A equipe de Superinteligência da Microsoft também planeja usá-lo para geração de dados sintéticos e aprendizado por reforço.

Para desenvolvedores, a prévia do Maia SDK é o ponto de entrada crucial. Incluindo integração com PyTorch, um Compilador Triton, uma biblioteca de kernels otimizada e acesso a uma linguagem de programação de baixo nível (NPL), este SDK permite a otimização antecipada de modelos e cargas de trabalho.

Conclusão: O Maia 200 não é apenas um 'chip mais rápido'. É uma 'solução de sistema' integrada—do silício e rede ao resfriamento, pilha de software e operações de nuvem—projetada para redefinir a economia das cargas de trabalho de inferência. Isso sinaliza que a corrida pela infraestrutura de IA está se movendo além de meras comparações de especificações em direção ao Custo Total de Propriedade (TCO) e à integração do ecossistema. Será fascinante observar como o cenário competitivo com o AWS Trainium e o Google TPU evolui e como este hardware poderoso contribuirá para a democratização e redução de custos dos serviços de IA. Vamos ficar de olho! 👨💻👩💻